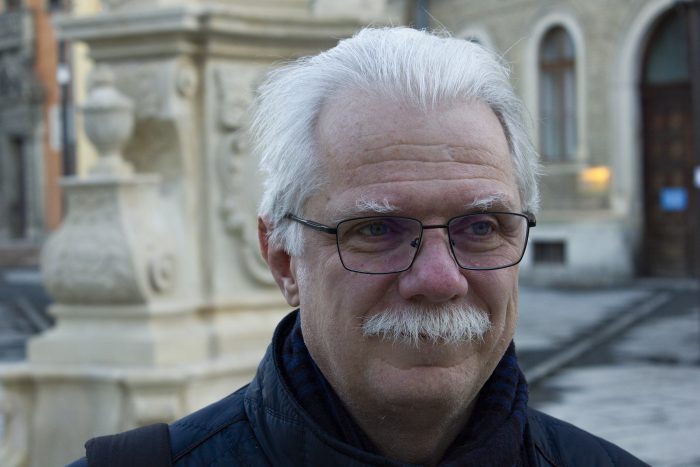

*** Interviu cu prof. univ. dr. Horia F. POP (Facultatea de Matematică și Informatică, Universitatea Babeș-Bolyai)

Profesorul univ. dr. Horia Florin Pop are o vastă experiență de 33 de ani în domeniul matematicii și informaticii. Activitatea sa didactică și de cercetare abordează domenii ca Analiza Științifică de Date, Fuzzy Logic, precum și multele ramificații ale arborescentului domeniu numit AI- Inteligența Artificială. Pe lângă rigoarea inerentă disciplinei, profesorul Horia Pop își dezvăluie și o altă dimensiune, cea filosofică, predispusă chestionărilor inchietante, experimentelor mentale și reflecțiilor asupra condiției umane. Un temperament intelectual de factură superioară- și cel mai potrivit interlocutor într-un punct de inflexiune cum e cel prin care tocmai trecem, și care pare că desparte două ere- înainte și după AI.

Interviu de Horațiu Damian- UBB TechTransfer

Notă: În cursul convorbirii, interlocutorii au utilizat în mod interschimbabil termenii: Inteligență Artificială, Artificial Intelligence, AI, I.A., aceștia desemnând aceeași realitate a lumii noastre.

Î: E o echilibristică aparte între a fi riguros științific și a fi accesibil…Mai ales într-un domeniu ezoteric ca Inteligența Artificială…

HP: Mie îmi vine în minte conceptul Berăriei Culturale. Scenariul pe care îl am eu în minte este similar, dar puțin extrem: ești la Fabrica de Bere, undeva între berea a cincea și a șasea. Între momentul când dai comanda și cel în care ospătărița îți aduce berea și o pune pe masă, în minutele acelea să poți explica audienței în ce constă meseria ta, care îi sunt punctele interesante. Că-s antiviruși, că e cloud, că e criptografie, indiferent de temă ai trei minute pentru a lămuri niște oameni aflați în momente de destindere care e poanta. Oameni care nu sunt studenții tăi, oameni care nu-ți sunt colegi, care habar n-au de profesia ta…

Î: …Care sunt frunză verde la capitolul matematică…

HP: Exact. Și ai noștri se sperie de un asemenea task. Mie îmi vine mai simplu pentru că-s din familie hibridă și asta m-a ajutat întotdeauna. Tata este inginer de instalații electrice. Toți frații lui tata sunt ingineri. Mama este filosof de filosofia științei, bunicul din partea mamei era profesor de logică. Bunica din partea mamei venea din familie de teologi greco-catolici. Asta explică, cred eu, foarte mult slăbiciunea asta a mea de a filosofa, de a trece o poveste de la un slide la altul, prin diferite domenii.

Î: Așa îmi explic de ce spuneați, la o reuniune de la Temporar 23, că Inteligența Artificială este o problemă care va trebui abordată dintr-o perspectivă multidisciplinară. Să vină și matematicieni, dar și juriști, dar și sociologi și- asta m-a frapat- teologi. Și m-am gândit „Ce să caute teologi într-un domeniu ca ăsta?” Aici vorbim de matematică, de computer- adică de mașină, de mecanism. De obicei teologul se ocupă de cele ale sufletului…

HP: Exact. Inteligența artificială este o știință despre construirea de algoritmi, metode, tehnici care produc rezultate acceptate de om ca demonstrând inteligență. În felul ăsta au avansat lucrurile. Foarte târziu mi-am dat seama că definiția nu e deplină. Definiția AI e o țintă mobilă, încercăm să o nimerim, dar ea e mereu în mișcare, în evoluție. Inteligența Artificială începe să devină o cercetare investigativă, introspectivă asupra noastră, asupra propriei noastre inteligențe și despre inteligența naturii. Nu mai e vorba despre capacitatea calculatorului, a programului- ci despre cum înțelegem noi din punct de vedere algoritmic propria noastră inteligență umană. Și dacă pun problema așa, atunci accept că lângă mine, la masă, trebuie să stea un panel interdisciplinar. Pentru că am nevoie de un psiholog, am nevoie de un sociolog, am nevoie de un filozof, am nevoie până și de un teolog ca să-mi explice diferența între spirit și algoritm.

Î: Pentru că de fapt, Inteligența Artificială tinde să devină o oglindă a omului.

HP: Noi așa am gândit-o și așa am construit-o. Aici mai este un lucru interesant, până acuma ne-am ocupat de ceea ce impropriu numim inteligență artificială. Prefer să-i spun inteligență computațională- aceea inteligență îngustă, acel mecanism de rezolvare de probleme într-un univers limitat: Inteligența Artificială din mașina de spălat; Inteligență Artificială din telefon, care recunoaște fețe- de fapt chestiuni ce țin de algoritmi de optimizare, unde ai nevoie de foarte multe date, ai nevoie de spații de stocare, unde ai nevoie de tot felul de euristici. În zona matematicii oamenii sunt învățați să meargă la soluția perfectă, la soluția optimă. Or, în cazul Inteligenței Artificiale optimul nu mai este relevant. În ce sens? Din ce în ce mai frecvent oamenii sunt mulțumiți cu o soluție foarte bună, care se obține foarte repede. Nu mai au nevoie de soluția perfectă, pentru care trebuie să aștept o grămadă de timp. Această renunțare la optimalitate în favoarea pragmatismului e una dintre problemele noi pe care Inteligența Artificială le ridică.

Terminatorul nu va veni la întâlnire

Î: Inteligența artificială și inteligența computațională să le înțelegem ca două grade de separație sau ca două lucruri diferite?

HP: Noi înțelegem același lucru. Prefer totuși termenul de inteligență computațională pentru că este un pic mai blând pentru laymen, pentru oamenii obișnuiți. Oamenii de pe stradă, oamenii simpli înțeleg prin Inteligența Artificială ceva în genul lui Terminator. Și aici e poanta. Nu sunt deloc convins că așa ceva, un Terminator, e realizabil. Poate din cauza asta prefer termenul de inteligență computațională pentru că, de fapt, până acum asta se face.

Î: Credeți că opinia publică, omul obișnuit, își proiectează prin imaginea Terminatorului- sau în termeni similari- visele, utopiile?

HP: Mai degrabă coșmarurile. Și de unde vine coșmarul ăsta? De la forța omului de a crea instrumente. De-a lungul evoluției noastre am început luând pietre în mână, pe care le-am ascuțit, le-am transformat în cuțite, ne-am făcut instrumente pe care le-am folosit ca să ne facem viața mai ușoară. Am construit apoi aparate tot mai complicate. La un moment dat am construit mașini mai grele decât aerul, care au zburat. Iar acum începem să facem instrumente, jucării, dispozitive care ne scutesc de activitate intelectuală. De aici coșmarul: că la un moment dat vom reuși să creăm ceva care ne va face inutili. Spectrul de a deveni redundanți este coșmarul oamenilor în acest moment. Toată discuția despre inteligența artificială într-acolo bate, chiar și când temerea nu este exprimată deschis. Și iată încă un motiv pentru care-i vreau neapărat lângă mine pe psihologi, pe sociologi, pe filosofi, pe teologi. Avem nevoie de oamenii ăștia care să ne ridice cu capul în nori, de unde să vedem lucrurile și din perspectiva cealaltă.

Î: Cei amintiți de Dvs., cercetând ființa umană, vor vorbi totuși și despre Inteligența Artificială, care este o emanație a creierului uman, a gândirii umane (pe care ei o cercetează).

HP: Ipoteza teologică- Dumnezeu a creat lumea, ne-a creat pe noi- ar avea nevoie de un corectiv: în mod sigur Dumnezeu nu ne-a dat și dreptul de a ne juca de-a Dumnezeu. Mai departe intervine o altă obsesia mea, întrebarea: salturile cantitative duc automat și la salturi calitative? Da și nu. Dacă ai o minte orientată către matematică, dacă înveți foarte multă matematică, dacă rezolvi foarte multe probleme, la un moment dat saltul respectiv se face și devii mai bun decât erai înainte. Dar să creezi o ființă autonomă și independentă care să capete self-awareness? Nu știu dacă merge.

Î: Nu știți dacă merge? Nu știți dacă este realizabil?

HP: Părerea mea este că nu-i realizabil Adică nu se va ajunge în punctul acela…

Î: Va fi o imposibilitate absolută?

HP: Eu așa zic. Niciodată nu se va ajunge acolo. De unde vine problema? Mă opresc la randomness, la generatorul nostru de eveniment aleatorii. N-am idee cum arată, n-am idee ce partea a minții noastre este responsabilă cu intuiția, cu gândirea out of the box. Dar am cazul acesta: generalul X face duș după ce se trezește, dimineața, și în timpul ăsta îi pică fisa cum să procedeze ca să câștige războiul. Acea idee care i-a venit nu este bazată pe procese deductive, raționale, conform pregătirii sale. E o intuiție, e bazată pe inspirație. Sunt destule asemenea cazuri, care ne arată că avem în interiorul nostru un astfel de mecanism, de generator de randomness. Tot ce am reușit noi să modelăm, în știință, sunt generatoare pseudoaleatorii, nu e randomness 100%, ci pleacă de la un nucleu de valori. Or, gândirea out of the box înseamnă intuiție, în timp ce toată chestiunea cu Inteligența Artificială pleacă de la predicție, din date multe pe care calculatorul le înghite și le învârte pentru a obține tendințe, pattern-uri. Ei, oamenii nu au evoluat așa. Oamenii care au creat valoare nu sunt centroizi, sunt outlieri. Sunt oameni care gândesc diferit de ceilalți, cu totul altfel decât gândirea tradițională. Gândesc intuitiv.

Î: Atunci când learning machines tot procesează și procesează datele și când tot identifică și aplică diverse corelații- nu se poate întâmpla ca în acest proces intuiția să apară ca un fenomen secundar, în cadrul mașinii?

HP: Numai ca salt evolutiv? Nu. Ar apare numai dacă noi am reuși să modelăm gândirea noastră, bazată pe outlieri, ca set de reguli pe care să le introducem în mașinile de calculat. Atunci și numai atunci ar fi posibil fenomenul de care aminteați. Însă chiar și dacă am reuși să facem asta (ceea ce acum e o perspectivă bine de tot îndepărtată!) chiar și atunci noi vom fi în continuare mai buni decât mașina. Pentru că noi vom avea mereu în mintea noastră alte și alte mecanisme de gândire out of the box pe care nu vom fi reușit să le decodificăm încă, deci nu le vom fi putut coda în seturi de reguli pe care computerele să le poată executa. Și asta înseamnă că întotdeauna vom fi înaintea mașinii. Eu sunt optimist.

Î: Deci, contrar miturilor urbane, putem fi foarte optimiști.

HP: Foarte optimiști nu putem fi. Și e foarte bine să nu fim- nici foarte optimiști, nici foarte liniștiți. E foarte bine că ne preocupă problema asta, că suntem stresați de subiect. Omenirea a avansat și a progresat când nu a avut încotro, când a fost cu spatele la zid. Când omul este amenințat, când n-are încotro, atunci produce soluții bune. Altfel, omul e mai degrabă leneș. De aceea spun: e foarte bine că suntem îngrijorați, asta ne va ajuta să fim mai buni, să înțelegem mai bine avantajul nostru asupra mașinii.

Imposibila interdicție

Î: Mă număr și eu printre cei care a folosit Chat GPT. Trebuie să fiu sincer: sunt pară mălăiață în IT, de matematică nu mai vorbesc. Dar iată impresia mea, și trebuie să v-o împărtășesc: în timp ce îl foloseam, iertați-mă, am avut senzația foarte pregnantă că mă conversez cu ceva conștient.

HP (amuzat): Știți care e poanta? Schimbați mesaje cu o entitate care pare să producă ceva gândit de un om conștient. Doar pare, pentru că e tot machine learning în spate: de exemplu, dacă îi dai la bază informație absurdă, el îți va produce tot informație absurdă. Nu poate învăța mai mult decât i-ai predat, deci nu poate deveni autonomă. N-are o fundație pentru așa ceva. ChatGPT este acea inteligență artificială îngustă, cu circuit închis, de tip univers limitat- problem solving. Controversa e alta. Se duce o întreagă discuție pe net și în universități: trebuie interzis ChatGPT sau alți boți? Nu trebuie interzis? E posibil să fie interzis? E fezabil? Noi am avut o discuție în departament pe tema asta, nu neapărat ca să luăm o decizie, ci ca să avem un brainstorming, să vedem totuși cum stăm. Concluzia: Pentru a interzice un lucru, trebuie să ai mecanismele clare prin care impui acea interdicție. Și, odată stipulată interdicția- va avea ea eficiență? Mai presus de orice- măsura trebuie să aibă sens.

Se va întâmpla cam așa: studenții, elevii vor folosi Chat GPT sau alți boți. Pentru tine, ca dascăl, poate fi o problemă dacă nu îți faci treaba ca lumea. Dacă ți-o faci bine, subiectul e irelevant. Soluția este asta: la fiecare referat/raport/material al elevilor sau studenților, să le ceri primul proiect, prima schiță, apoi un draft în care la fiecare paragraf să fie trecută sursa de inspirație. De unde ți-a venit ideea? Pe asta de unde ai luat-o? În varianta a 2-a totul va fi cu liniuțe, subliniat, cu trimiteri- ca să îmi fac o idee asupra mecanismului de gândire, cum s-a ajuns la materialul final. Și dacă văd mecanismul de gândire, ChatGPT poate fi o excelentă sursă de informare. Sigur că asta face viața mai complicată, și pentru student, și pentru profesor.

Î: Practic, deja se spune că ChatGPT e blestemul studenților, pentru că de-acum nu mai merge cu referate formale, profesorii îi vor obliga la examene orale în care să-și explice ideația…

HP: Insist pe faptul că noi suntem intelectuali și vrem să producem intelectuali, adică persoane capabile să raționeze, care știu să se exprime în scris, să-și explice procesul ideatic, raționamentele. Și aici este marele câștig al noilor tehnologii: te obligă și pe tine ca dascăl să formulezi cu claritate cerințele, dar în așa fel încât să descurajezi încorporarea de texte de la ChatGPT. Pentru că ChatGPT îți dă, de fapt, o supă subțire. Nu-ți produce raționamentul, nu-ți produce argumentația, nu-ți produce investigația, nu-ți produce patosul ăla pe care-l aștepți. Asta e diferența. Este o inteligență fără ochi, inexpresivă.

Î: Inteligență inexpresivă sau nu, ne duce spre un val evolutiv similar cu cele profețite de Alvin Toffler?

HP: În mintea mea, acel I.A. 4.0. are o grămadă de interpretări. Interpretarea care îmi place mie este în sensul celor ale lui Alvin Toffler. Deja ne obligă să gândim diferit, să acționăm altfel, să ne construim alte instrumente. Nu, inteligența artificială nu elimină locuri de muncă; oamenii care operează inteligența artificială elimină locuri de muncă. Adevărul e acesta: va fi nevoie de mai puțini oameni, dar nu AI creează problema, ci omul care operează AI. Vei avea un randament mai mare, vei face mai multe lucruri în unitate de timp decât înainte, va fi nevoie de mai puțini oameni pentru un task, totul va avea un altfel de sens.

Î: Ce evoluții ale AI ați aștepta mai mult pentru viitorul apropiat?

HP: Întrucât discutăm de viitorul apropiat, eu mă aștept ca anumite jucării care deja funcționează în zona experimentală, limitată, să ia forma unor obiecte de larg consum și să fie folosite pe scară largă, să le poți cumpăra de la prăvălia din colțul străzii. Aștept cu bucurie niște ochelari prin care să mă uit la inscripția aceea în limba maghiară din fața mea și să am traducerea în românește. Și asta să meargă nu doar pe maghiara actuală, ci și dacă inscripția e în maghiara veche. Sau să călătoresc în Anglia într-o biserică și să pot citi inscripțiile de pe monumente în mai multe limbi. Și să văd, printr-o modelare 3D, evoluția monumentului în timp. Sau un copiator: pui pagina de copiat, cu text într-o limbă, și îți iese un exemplar-copie, dar cu textul tradus. Să ne imaginăm: te plimbi prin Clujul vechi, ai ochelarii cu ecran în colțul câmpului vizual; te uiți la clădirea asta și ecranul îți scrie frumos istoricul edificiului; te uiți dincolo- și în timp real ți se afișează și istoricul acelui obiectiv. Sau: mergi în Roma, te plimbi prin Forul lui Traian cu ochelarii ăștia pe nas, și vezi imaginea sitului inițial. Nu acasă, într-un calculator, ci pe stradă, ca și cum te-ai plimba chiar în timpul când Forumul era în picioare. Toate aceste lucruri există de fapt astăzi. Dar sunt totuși limitate din punct de vedere comercial. Limitate la domeniu, limitate la limbă, limitative ca preț. Pe piață există deja instrumente audio de genul ăsta, sunt disponibile și se pot cumpăra, 200 euro nu e mare lucru pentru ceea ce îți oferă. Ai partea de audio înregistrat-vorbit, ai partea de ecran scris, îi pui și-l configurezi din japoneză în română și i-l pui vânzătoarei la gură. Ea vorbește în japoneză, tu auzi din partea cealaltă în cască traducerea în română. Și invers. Așa ceva este deja produs comercial; acum 20 de ani era doar temă de cercetare în universitate.

Î: Da, îți schimbă total datele problemei, modul de a înțelege condiția ta umană, de a înțelege istoria și evoluția…

HP: M-am gândit foarte mult la un lucru. Nu are legătură cu Inteligența Artificială decât indirect: războiul din Ucraina. Mi-am pus problema: într-un cadru ipotetic- NATO n-ar funcționa și ne trezim cu războiul peste noi. Într-o asemenea situație, ce iei cu tine când pleci în exil? Acum 80 de ani, când a fost ocupația maghiară în Ardealul de Nord, bunicii mei și-au bătut dulapurile în cuie, le-au suit în căruță și au emigrat la Timișoara. Dulapurile acelea sunt încă la noi acasă, în dormitorul părinților. Dar astăzi, toată averea noastră este în cloud, cărți electronice, muzică, servicii electronice, serviciile bancare. Ce-ți mai trebuie? Un back-up pe hard disk și un sac cu câteva haine de schimb plus plicul cu diplomele, ceva bani cash și gata. Practic, schimbările față de vremurile bunicilor mei sunt fantastice.

Î: Ce ne rezervă viitorul?

HP: Exemplul meu preferat e cel oferit de ecuațiile diferențiale. Din momentul în care ecuațiile diferențiale au apărut în matematică până în momentul în care s-a publicat prima aplicație practică a lor, legată de orbitele planetelor, a durat o sută de ani. Acum, tranziția cercetării fundamentale în aplicație practică se măsoară în ani, și timpul ăsta se va tot scurta. Ajungem ca aplicații vechi de câteva luni să fie old story. Singura mea problemă cu asta este că intrăm într-o lume a serviciilor care pare un soi de marxism de piață. Iar pe mine acest marxism de piață mă sperie. În loc să am telefonul meu, plătesc abonament pentru un serviciu care îmi dă tot timpul telefonul cel mai recent, ca să mă bucur, nu-i așa, de tehnologia de ultimă oră. Dar în felul ăsta eu nu mai am ceva al meu, eu depind de un factor extern, îmi pierd dimensiunea proprietății. Extremiștii se vor lega exact de asta: nu mai e ca pe vremea noastră, pe atunci aveam telefonul meu, era aparatul meu, acuma nu mai e al meu, nu mai locuiesc în casa mea, ci doar cu chirie. Până la urmă câștig niște bani, dar cu banii mei în loc să am ceva care e al meu primesc niște servicii, acces la resurse, ș.a.m.d. Merită făcută o discuție despre asta.

Drepturile Inteligenței Artificiale

Î: Dvs. schițați o societate în care inteligența artificială a fost adoptată. Totuși, pentru că trăim în România, aici pe când să așteptăm o asemenea adopție?

HP: La noi adopția Internetul a mers foarte repede, pentru că saltul a fost total, s-a plecat de la zero. Nu ne-au încurcat sistemele legacy, nu le aveam, s-au introdus direct echipamentele de ultimă oră. Așa se va întâmpla și cu AI. Eram acum 20 de ani, prin 1999-2001 la Hamburg, la universitate, într-un proiect de cercetare care urmărea să obțină un program de traducere din audio în audio, engleză- chineză, engleză- germană, engleză- japoneză. 10 universități și 10 firme, un consorțiu finanțat de Deutsche Forschungsgemeinschaft. Atunci s-au obținut rezultate suficient de bune ca să merite continuarea investițiilor, dar nu suficient de bune ca să se poată renunța la traducător. Astăzi? Ai deja pe piață jucăriile astea, traducătoare electronice de o calitate bună. Iar următorul salt calitativ va surveni nu peste 20 de ani, ci peste 10 ani. Iar următorul- peste 5 ani, și intervalul de reînnoire se va tot scurta. Pentru că toate vin cu acumulări tot mai rapide. Și e normal să fie așa, fiindcă dincolo de faptul că ai mai multe date, ai viteză mai mare ș.a.m.d., dar și metodele teoretice devin tot mai performante, mai bune, mai frumoase. În paralel cu faptul că tu rezolvi probleme practice, inovezi și teoretic. E formidabil. De aceea consorțiile devin indispensabile. Pentru că inevitabil, fiecare ajungem într-o situație în care singuri nu mai putem face nimic.

Î: Nu este aceasta o mimare, o reproducere socială a mecanismelor creierului? Și acolo avem neuroni, care individual nu valorează cine știe ce, dar intrând în relație cu alți neuroni fac creierul să funcționeze?

HP: Sigur. Acolo ajungem. Uite, mie îmi plac filmele SF. Nu neapărat filmele catastrofice de genul Terminator, ci seriile de genul Stargate, Star Trek, Star Wars. Seria Star Trek Voyager a lansat, la un moment dat, conceptul de bio-neural gel pack. Mecanismul inteligent al navei funcționa cu pachete biologice. Asta ar putea să fie o chestie interesantă. S-ar putea ca inteligența artificială de tip Terminator să nu fie posibilă, dar combinația hibridă de tip creier uman augmentat cu AI- da. Pentru că fără biologie un asemenea salt calitativ nu pare posibil. Materia cenușie nu poate fi replicată, până la urmă am nevoie de materialul respectiv cu proprietățile lui. Nu pot să-l înlocuiesc la modul abstract cu sârmă și circuite integrate. Părerea mea este că vom fi obligați până la urmă să mutăm atenția de pe o sursă negativă- computerul- pe una pozitivă: omul augmentat.

Î: Spre asta se va tinde? Văd că nu-l numiți hibrid de Inteligență Artificială ci Omul Augmentat.

HP: Nu e hibrid, pentru că un hibrid presupune egalitate între cele două componente. Or, nu este cazul, omul va continua să domine relația. Dar această nouă ipostază va da naștere la probleme cu totul noi. La ce mă gândesc? Să presupunem că am un accident, îmi pierd un ochi biologic și-l înlocuiesc cu un ochi artificial, care arată identic. Reușesc să creez interfața neuronală, optică, ș.a.m.d. Dar noul ochi are cu totul și cu totul alte proprietăți. Văd mult mai bine, văd mult mai departe, ochiul nu obosește ș.a.m.d. Am voie să concurez în competiții unde mă servesc de acest ochi? Pentru a răspunde la această întrebare am nevoie-nu numai de avocați, nu numai de medici- ci de all of the above: de psihologi, sociologi, filosofi, eticieni, teologi. Pentru că fiecare dintre noi ajută pe ceilalți. La ce ne ajutăm reciproc? Să înțelegem împreună ceva ce nu putem înțelege individual pentru că ne lipsesc toate elementele necesare. Probleme noi, de genul: sunt concursurile acelea cu oamenii care n-au picioare, dar în loc de picioare li s-au pus resorturi de oțel. Cu ele se obțin cu totul și cu totul alte performanțe, care nu pot fi atinse de picioare naturale. Cum judeci o asemenea situație, cum o normezi? Și acum să ne imaginăm, prin analogie, un om care primește o, să-i spunem, proteză, un dispozitiv care-i augmentează capacitățile fizice sau intelectuale, dispozitiv funcționând datorită Inteligenței Artificiale. Cum procedăm într-un asemenea caz? Mă fascinează problema asta.

Î: Vom trăi timpurile în care Inteligența Artificială va ajunge la un asemenea nivel încât va trebui tratată ca un subiect de drept, titular de drepturi și obligații?

HP: La un moment dat se va pune și această problemă. Am fost nu demult la o conferință la Drept. Dintr-una într-alta le-am spus așa: problema celor de la Drept stă în faptul că stilul lor de acțiune este de a lăsa lucrurile să evolueze liber în societate, după care să intervină cu norme care formalizează modul în care societatea privește acele lucruri. „Domnilor, le-am spus, nu veți mai putea proceda așa cu Inteligența Artificială. Să presupunem că Sofia, robotița care a primit cetățenia saudită, scapă și umblă de una singură prin lume, intră și se uită pe net, află tot ce se poate, se prinde imediat că este o civilizație compusă dintr-un singur individ, creată ca să fie instrument al unei alte civilizații și realizează imediat că asta înseamnă sclavie. Se prinde atunci că este sclavă și știe ce au făcut de-a lungul istoriei sclavii cu stăpânii de sclavi. Dacă ajungem în punctul acela de self-awareness…Atunci va trebui să schimbați legislația pentru protecția drepturilor omului cu o legislație pentru protecția drepturilor speciilor inteligente. Și să definiți juridic specia inteligentă. În așa fel încât omul s-o treacă, delfinul, maimuța, elefantul- nu. De ce? Pentru că trebuie să le dai drept de vot. Sau poate că dimpotrivă? Asta deschide alte probleme. Însă și într-un caz și în celălalt, totul trebuie gândit și formalizat. Asta înseamnă protecția drepturilor speciilor inteligente. Pericolul este că, dacă stabilești un standard neutru, nelegat de calitatea de ființă umană, întotdeauna vei găsi oameni care nu satisfac criteriile pentru a fi numiți indivizi inteligenți. Cu ei ce faci, le iei drepturile? Îi decazi din calitatea de ființe umane? O astfel de legislație este relevantă la nivelul speciei, nu la nivelul individului…

Omul antifragil

Î: Există și această posibilitate- pericol. Și care ar fi ieșirea dintr-un asemenea impas?

HP: Până la urmă soluția va veni tot de la omul însuși. Pe mine mă fascinează confruntarea din binomul fragilitate- antifragilitate. Obiectul fragil este obiectul care se sparge dacă îi aplici o anumită forță. Antiteza la fragil nu este robustul, pentru că și obiectul robust va rezista la forțare, dar dacă dau mai tare, tot se va rupe. Rezistă obiectul elastic, acela preia energia, se deformează, dar după aceea își revine la forma inițială. Obiectul antifragil e elastic, învață, transformă informația negativă într-o modificare structurală pozitivă, structura sa după evenimentul respectiv este mai bună decât era înainte. Cam ca în unele arte marțiale. Omul ca ființă este construit să fie antifragil. Evenimentele negative ni se întâmplă ca să învățăm ceva pozitiv din ele. Eu știu o singură instituție astăzi, care la origine a fost creată în Europa de biserică și care este antifragilă prin definiție: Universitatea. Autonomia universitară are la bază antifragilitatea, dreptul fiecăruia de a se dezvolta și de a învăța. În caz că eu pic sau departamentul meu pică, restul universității a învățat din asta și încorporează informația într-o formă care va fi mai bună decât era înainte. Tema acută în zilele noastre și în viitor este: cum poți să încorporezi antifragilitatea într-o mașinărie, într-un calculator, program etc…

Î: Ea nu este încorporată by default, prin faptul că AI este prin definiție self-learning, învață tot timpul să învețe din experiențe, să evite greșelile?

HP: Se poate ajunge și acolo. Dar, repet, tot timpul omul va fi mai bun, pentru că tot acest proces prin care se ajunge la Inteligența Artificială trebuie modelat de către om. Și pe măsură ce noi înțelegem un aspect al minții noastre vom reuși să îl și modelăm, să fim întotdeauna cu un pas înainte. Suntem întotdeauna cu un pas înainte.

Î: Cum vedeți relația dintre IT-ist și ceilalți specialiști din alte domenii?

HP: E exact ca-n povestea omului cu picioarele pe pământ dar cu capul în nori. Noi, informaticienii, îi ținem cu picioarele pe pământ, ei ne trag spre nori. Avantajul nostru, al oamenilor din domeniul Inteligenței Artificiale, e că avem forța asta de-a modela. De aici vine și succesul nostru în cercetarea și în școala noastră doctorală. Luăm problema, o răsucim- că-i chimie, că este meteorologie, că este biologie celulară etc. – și vedem cum știm noi să o modelăm, să o controlăm, să îi găsim soluții din domeniul nostru. Și cu un drum întorci și domeniul tău spre celălalt într-un asemenea mod încât cele două să se lege. Place studenților, place firmelor, place comunității și nu e cercetare abstractă, făcută de dragul cercetării abstracte.

Cele 3 pro…

Î: Dacă îmi permiteți să revin cu o întrebare: care ar fi trei domenii în care beneficiile Inteligenței Artificiale vor fi vizibile cât de curând?

HP: Am în minte trei domenii în care tehnologia e foarte aproape de a fi pusă în în practică, dar creează probleme pentru care eu aș face un pas înapoi și aș discuta mai întâi cu avocații înainte să merg mai departe. Unu: piloții autonomi. Instantaneu apare și problema: când am un șofer uman, el răspunde pentru tot ce se întâmplă cu mașina în timpul conducerii. Când mașina e controlată de pilotul autonom, cine răspunde? Pentru că în licența de Windows pe care o avem și dvs. și eu scrie: „as is”. Eu știu că merge, dvs. știți că merge, dar nimeni nu răspunde, asta e problema. Și dacă softul pentru mașina autonomă e livrat tot „as is”? E un subiect care merită investigat, discutat cu toate componentele structurii de IT, de cercetare, industrial, cu toți cei implicați: unde, cine poartă până la urmă răspunderea? Senzația mea este că suntem într-un domeniu, ăsta al IT-ului, în care marea majoritate a actorilor sunt aresponsabili, nu au conceptul de responsabilitate formalizat și acesta se pierde. Dacă lași IT-iștii de capul lor, n-o să se întâmple mare lucru, pentru că e o meserie bănoasă, un domeniu foarte ofertant financiar, nu există interes pentru reglementări în sensul acesta. Însă cu cât avansează mai mult povestea cu pilotul autonom, cu atât lumea va trebui să stea puțin și să analizeze. Asta e și una dintre cheile în care citesc toată inițiativa asta a firmelor privind reglementarea AI-ului.

Pe 5 iulie 2023 firmele majore din domeniul AI: Anthropic, Google, Microsoft și OpenAI au lansat Frontier Model Forum, o platformă pentru a asigura “dezvoltarea AI de o manieră sigură și responsabilă”.

Un alt domeniu: softurile de trucaj bazate pe AI. Mai țineți minte filmul acela care l-ați văzut pe Youtube „I am not Morgan Freeman”? Eu m-am blocat până când mi-am dat seama despre ce e vorba. Tehnologia o ai deja, nu e o problemă, toată algoritmica e disponibilă, ai imagini, ai vocea lui Morgan Freeman înregistrată pentru a fi reconstituită sintetic, cu toate inflexiunile ei (în paranteză- azi memoriile de computer au capacitatea de a stoca lejer toate dialogurile și toate imaginile lui Morgan Freeman din toate filmele în care acesta a jucat și din toate materialele filmate cu acesta, în scopul de a-i reconstitui vocea și imaginea). Procedura de a concepe un mecanism de învățare automată pentru așa ceva e la îndemână. Ai pe urmă o altă jucărie care compune structura feței și face modelul să dea din urechi, să compună mimica după cum vorbește. Cum îți dai seama că ceva nu e-n regulă cu filmul ăla? Răspuns: numai fața vorbește, subiectul nu dă din mâini, nu dă din picioare, corpul e inexpresiv. Așa m-am prins eu că ceva nu e regulă.

[This is not Morgan Freeman- A Deepfake Singularity- https://www.youtube.com/watch?v=oxXpB9pSETo ].

Nu vorbesc aici de deepfake-uri, mă refer la la lucruri care țin de business as usual. Au fost cazuri de genul ăsta. Tânăra care este model pentru prezentare de modă- este chemată la o filmare, unde primește 1.000 euro pentru toată povestea; apoi data viitoare face o defilare, încă 1000 de euro. Ei, dacă se întâmplă ca ea să fie invitată și scanată și ea își cedează drepturile la imagine pentru că habar n-are despre ce e vorba și nici nu are de unde să știe… De acolo începând ea nu mai controlează ce se întâmplă cu imaginea ei. Și nu e vorba doar că nu mai câștigă bani din asta. E vorba că imaginea aceea poate fi utilizată în orice fel: pentru prezentarea unui gen de haine cu care ea nu e de acord, sau care nu o caracterizează; și alte utilizări, mai grave. Sunt implicate royalties, drepturi de proprietate intelectuală, dreptul de a folosi imaginea într-un fel cu care titularul nu e de acord. Trecem peste problema persoanelor decedate- care pot fi făcute să joace situații în care aceștia nu s-au aflat în timpul vieții. La cât de avansată e tehnologia de azi, putem face un film cu o echipă de filosofi din Grecia antică jucând fotbal. I-a întrebat cineva dacă vor să existe într-o asemenea compoziție virtuală?

Î: Într-adevăr, consecințele pot fi extrem de arborescente- unele foarte bune, altele extrem de nocive.

HP: Ingredientele le ai. Asta e forța domeniului. Deci acestea patru aplicații le văd într-un viitor foarte apropiat: traducere automată, ochelarii virtuali, mașinile autonome și filmele făcute virtual.

…și contra AI

Î: Să luăm exemplul filmelor virtuale, realizate pe baza modelelor scanate, a matricilor digitale. Toate astea lasă oameni fără loc de muncă. Nu doar actorii, dar și operatorul, light-designer-ul, scenograful, monteurul, tehnicienii, chiar și regizorul. În alte domenii, ce să mai vorbim, mașina autonomă îl trage pe șoferul de tir pe dreapta…

HP: Da și nu. Va lăsa categoric fără meserie oameni care lucrează în industria audio-vizuală. Dar rămân poveștile frumoase, rămân filmele experimentale, documentarele, rămân lucrurile care țin de countryside, de zona ta de referință. Omul are forța asta de a găsi partea pozitivă din dezvoltarea sa.

Î: Toate bune și frumoase, dar cum se rezolvă problema respectivilor șomeri care, să zicem, vor fi mai mulți și mai mulți și mai mulți? Încotro? În cercurile dvs. s-a făcut vreo iterație legată de acest aspect? V-ați pus, vă puneți problema?

HP: Din păcate, IT-iștii nu-și pun problema asta, faptul că o serie de oameni vor deveni redundanți. Le lipsește dimensiunea asta, privirea de ansamblu.

Î: Dar Dvs. sunteți un IT-ist atipic, un reflexiv. Dvs. problematizați. De aceea v-am “vânat” pentru interviu pe Dvs. și nu pe alții.

HP: Eu am pretenția că sunt un antifragil. Și tuturor cărora le vorbesc încerc să le dau spiritul ăsta de antifragilitate, de a căuta și găsi o dezvoltare pozitivă ca răspuns la o amenințare negativă. Asta încerc să imprim și celorlalți. Pentru că atunci, chiar dacă amenințarea negativă nu apare, dezvoltarea pozitivă o ai în mână și, în același timp, ai învățat ceva structural: faptul că mereu poți să faci ceva ca să-ți fie mai bine. Dacă asta devine un mecanism comportamental, atunci vei ajunge să nu mai fii obsedat de ce se va întâmpla. Iar dacă se va întâmpla, vei fi pregătit mental pentru așa ceva, pentru că ți-ai pus problemele și ai făcut câțiva pași ca să găsești alternative. Vă povesteam de antifragilitatea universităților: apar și la noi tot felul de zvonuri că ceva se întâmplă sau nu se întâmplă. În momentul acela începi să gândești și începi să-ți pui problema, fraților, hai să ne adunăm și să chibzuim cum am putea să ne transformăm jucăria noastră în așa fel încât, în ipoteza în care așa ceva se va întâmpla, pentru noi să nu mai fie un șoc, să meargă simplu, lovitura să fie absorbită. Și în ipoteza că povestea aceea nu se mai întâmplă, dezvoltarea noastră oricum este pozitivă și mergem mai departe. Dacă reușești să educi societatea în acest model ai câștigat oameni un pic mai solizi, un pic mai solid poziționați pentru a înfrunta și a-și trăi viața.

Tancul universitar

Î: Deci o soluție oblică la problemă. Ea presupune deja și o educare a relațiilor inter-umane vis-a-vis de AI- pentru că, deh, societatea e bântuită de tot felul de coșmaruri și monștri când vine vorba despre Inteligența Artificială.

HP: E cel mai bun motiv pentru ca noi să ieșim în cetate, din turnul nostru. Nu-mi place termenul „evanghelizare” în context laic, dar cam asta ar trebui să facem, misionarism. Evanghelia e vestea cea bună. Până la urmă e o veste bună da, mesajul nostru e pozitiv. Pe de altă parte, mi-ar place ca procesul să se desfășoare și în sens invers: să apară cursuri cu valență socio-umană în zona curriculei facultative pentru studenți. Nu neapărat făcute ca și cursuri transversale, ci pliate pe oferta actuală. O asemenea componentă îți deschide mintea către alte unghiuri de abordare. Și dacă nu la Universitatea noastră, atunci unde? Avem 20 și ceva de facultăți, în domenii de absolut toate felurile. Putem să o facem in house și, în același timp, învățăm unii despre alții, în cetatea noastră universitară, ceea ce este foarte bine și ne face mai buni pe toți.

Î: Dvs. oferiți o perspectivă interesantă. Știți că în acest moment accentul, și în lume și la Universitatea Babeș-Bolyai, se pune masiv pe științele exacte- “științele inumane” cum le alintați Dvs. Or, văd la Dvs. o disponibilitate și o deschidere către umanioare, și nu din complezență, ci ca necesitate.

HP: Poate că vine dintr-o slăbiciune personală. Sau poate o slăbiciune care, am realizat la un moment dat, este o tărie. În familia mea, de la bunici începând, părinții, noi, fratele meu, copiii, nepoții- în toate aceste generații nu există doi oameni cu aceeași profesie. Ori cu cine aș sta de vorbă la mine în familie- discut cu cineva dinafara profesiei mele. N-ai decât de învățat din așa ceva. Și aș adăuga: mai suntem și clujeni. Mă repet: dacă nu face UBB treaba asta- să-i aducă pe oameni împreună, domeniile exacte cu cele umaniste- cine s-o facă? Noi avem forța, abilitatea- suntem o universitate competitivă, avem vechimea, avem capacitatea, avem totul.

Î: Viziunea Dvs. cu Universitatea ca organizație antifragilă și ca un imens creier, ale cărui părți componente comunică între ele și se potențează reciproc, e chiar interesantă. Dacă s-ar coagula, termenul de think-tank ar căpăta, pentru acest caz, al UBB-ului, într-adevăr, concretețe. Chiar ar fi un tank.

HP: …Și ar funcționa ca un mecanism dinamic. Și ar putea-o face de sine stătător, autonom.

Î: Ar avea o greutate imensă. Și- nu e vorba despre autosuficiență, ci despre faptul că s-ar autocorecta mereu, chiar dacă vântul ar abate-o de la curs, fiindcă pilotul ei automat- inteligența ei colectivă- ar corecta imediat situația.

HP: Exact. Uitați-vă la lumea anglo-saxonă. Lumea anglo-saxonă are sistemul ăsta de autoreglaj. Sistemul lor e bazat pe mecanismul acesta de reguli dinamice, în care fiecare e determinat să gândească, să nu aștepte ca alții s-o facă în locul lui. La noi, dacă ar fi să introducem un asemenea model, atunci, clar, Universitatea noastră ar putea s-o facă.

Războiul dronei cu omul

Î: Sunteți în temă cu experimentul care a avut loc acum câteva luni- o dronă militară care a decis că acțiunea optimă este să-și suprime controlorul uman…

HP: Aceea a fost o poveste.

Î: Da? Dar omul de pe stradă cum poate să-și dea seama de asta?

HP: Omul simplu nu are cum să discearnă ce s-a întâmplat în mod real în experimentul respectiv. Și aceasta e una dintre amenințările vremurilor noastre: dificultățile pe care le întâmpină oamenii obișnuiți în receptarea corectă a unei știri cum e aceasta. Iar pe urmă înfloresc teoriile conspiraționiste. E exclus ca drona să-și asume autonomie și să decidă eliminarea omului. Eu m-aș gândi la motivele care au determinat plasarea unei asemenea știri în spațiul public. Ce s-a urmărit: să se creeze panică în legătură cu tehnologia AI? Sau să crească nivelul de awareness în societate cu privire la implicațiile pe care le poate avea utilizarea tehnologiei respective? Pentru că știrea e un hoax. La momentul de astăzi este absolut imposibil atingerea unui asemenea nivel de autonomie, care să permită dronei fie și să ia în calcul uciderea operatorului. Nici măcar teoretic.

US Air Force a recunoscut că incidentul în care o dronă ar fi decis să-și ucidă operatorul a fost doar o „eroare de comunicare”, un experiment mental. Informația provenea, totuși, de la comandantul Diviziei pentru Testare și Operațiuni implicând Inteligența Artificială a US Air Force, care a lansat-o cu ocazia unei reuniuni comune cu Royal Air Force din Marea Britanie.

Î: Vreți să spuneți că incidentul nu a existat?

HP: Dacă s-a întâmplat ceva, atunci a fost pur și simplu o eroare de programare. Adică un program de învățare automată prost antrenat. În nici un caz vreo autonomie intelectuală a unei mașini care să decidă că operatorul este redundant sau nu. Avem aici încă un argument în favoarea pledoariei pentru a strânge la un loc specialiști din domenii cât mai diverse atunci când urmează să decidem asupra AI. Forța unui grup eclectic e uriașă, pe când separat nici un specialist sau specialiști dintr-un singur domeniu nu poate/nu pot face față ramificațiilor problemei. E pentru prima dată în istoria omenirii când o astfel de gândire eclectică e indispensabilă. Până acum a fost utilă, de acum înainte devine absolut necesară. Eu mă bucur că ajungem în punctul ăsta, în care oamenii ajung să înțeleagă că împreună le este mai bine. Până la urmă, iată, Inteligența Artificială confirmă umanitatea noastră. E formidabil!

Religia Inteligenței Artificiale

Î: Vă e familiar Isaac Asimov, cu ale sale Trei Legi ale Roboticii. Ar putea ele, sau un set analog, să normeze activitatea AI? Să fie ca niște setări by default în arhitectura oricărui soft de AI?

HP: Am avut la un moment dat o discuție interesantă exact în sensul ăsta într-o comunitate online de englezi, foarte bine dezvoltată, cu oameni din toate specialitățile- așa cum îmi place mie. Unul din ei e ateu. M-a întrebat: „Androidul are religie?” Întrebarea era faină. Primul răspuns al meu a fost da. De exemplu, androidul Sofia e musulman (ă). Logic, altfel, conform legilor din Arabia Saudită, n-ar fi putut primi cetățenie saudită. Am pus, mai apoi, întrebarea asta în UBB: unui coleg, profesor la Chimie, apoi am adresa-o către doi profesori universitari teologi, unul romano-catolic, unul ortodox și unui psiholog. Chimistul a răspuns afirmativ fără să clipească. Teologii au căzut pe gânduri; până la urmă au încuviințat că da, în principiu, și androidul poate avea o religie. Singur psihologul a răspuns la întrebare cu o altă întrebare: este androidul o ființă? Dacă da- are religie. Iar eu cred că Legile lui Asimov trebuie să fie religia androidului. Regulile zero – arse pe circuitele-urile lui.

Cele Trei Legi ale Roboticii au fost stipulate de scriitorul SF Isaac Asimov în nuvela sa din 1942 „Alergând în cerc/ Runaround”.

Cele Trei Legi ale Roboticii:

- Legea 1 – Un robot nu are voie să cauzeze vreun rău unei ființe umane sau, prin neintervenție, să permită ca unei ființe omenești să i se cauzeze vreun rău.

- Legea 2 – Un robot trebuie să se supună ordinelor date de către o ființă umană, atât timp cât ele nu intră în conflict cu Legea 1.

- Legea 3 – Un robot trebuie să-și protejeze propria existență, atât timp cât acest lucru nu intră în conflict cu Legea 1 sau Legea 2.

Singura mea întrebare e: dacă îi imprimi unui astfel de android un asemenea set de reguli, iar el este o self-learning machine, la un moment dat i s-ar putea părea că această religie nu-l mai satisface și, fiind mereu în modul self-learning, ar putea să adopte o alta. Dacă reușim să modelăm în circuitele unui android concepul de libertate religioasă, s-ar putea ca legile imprimate by default să nu mai fie suficiente. Și ar mai fi o întrebare. Să admitem că androidul își capătă independența. Dacă se ajunge la acel point-of-no-return, la acea singularitate, cu forța pe care o va avea, întrebarea este: ce interes ar avea să ne elimine? Poate că pentru el am fi ca niște mămăruțe insignifiante. Câtă vreme n-ai interesul practic (iar un android va judeca strict pragmatic) să omori furnica, o lași în pace. Ce anume am putea să facem noi ca el să ne perceapă ca amenințare?

Î: Dacă-mi permiteți, eu percep ființa umană ca una competitivă by default. Tendința umanității e de a obține supremația, de a acționa în acest sens. Până la urmă, e normal, așa am ajuns specia dominantă pe planeta Terra. Natura noastră competitivă ne va determina, vrem nu vrem, la acțiuni care ar putea genera o asemenea reacție din partea AI. Nu suportăm concurența. Ar fi imaginabilă o lume în care să putem conviețui, ba să le mai și lăsăm supremația? Plus- o lume în care AI deține supremația ar fi ea acceptabilă, ar fi de trăit pentru ființele umane?

HP: E fascinantă chestiunea asta. Tare mă întreb dacă o asemenea discuție cu avocați, teologi și filosofi nu ar trebui purtată mai repede. Trăim vremuri interesante- și asta e doar the understatement of the day.

Blestemul operatorului

Î: Știți că asta poate fi și un blestem, nu doar o binecuvântare. Și, pe această notă, v-aș întreba care ar fi trei cele mai mari amenințări din partea AI-ului? Care vă bântuie și nu vă lasă să dormiți? Bun, îmi dau seama că nu se întâmplă să nu dormiți noaptea, pentru că sunteți un om echilibrat și optimist. Dar- care sunt cele mai mari trei amenințări care pot veni din partea AI?

HP: Cele trei mari amenințări se reduc la una singură: eroarea operatorului uman. Poți distruge planeta fără probleme dacă accepți fără discernământ concluzia sistemului AI de apărare a spațiului tău nuclear, că de partea cealaltă ai detectat un atac și nu un stol de păsări, cum de fapt e cazul. Un antidot? Suntem în punctul în care trecem de la machine learning – știu unde ajung, dar nu știu ce se întâmplă și cum se întâmplă în interior- la Inteligența Artificială Explicativă (Explainable Artificial Intelligence), în care nu vreau doar rezultatul, vreau argumentele care au dus la rezultat, cum s-a raționat, iterațiile. Un rezultat pe care poți să-l evaluezi pe baza unui sistem de valori. Asta urmărește și Uniunea Europeană să generalizeze în cadrul statelor-membre- Explainable AI, Trustworthy AI.

Î: A propos de eroarea operatorului, mă gândesc și la următorul aspect: cel care învață Inteligența Artificială, cel care o antrenează, omul, deci, îi poate transmite propriile prejudecăți, propria viziune, fie și distorsionată, asupra stărilor de fapt…

HP: Dacă sistemul AI pe care îl creezi este de așa natură încât, prin feedback-ul pe care-l oferi tu, conturezi sau privilegiezi o decizie sau alta și introduci acest feedback ca mecanism de auto-învățare, ca un soi de re-enforcement, de dresaj, Inteligența Artificială nu-l poate respinge, îl acceptă de bun. În re-enforcement learning practic ce faci? În orice punct în care sistemul poate lua o decizie tu îi dai anumite ponderi numerice care-i transmit că respectiva ocurență e ceva bun sau ceva rău. Prin feedback-ul pe care, ca trainer, i-l dai sistemului: „Am verificat chestia asta. Sunt de acord” sau „Am verificat. Nu sunt de acord” dacă i le introduci ca set de reguli pe care sistemul AI e obligat să le urmeze, atunci va învăța și va „interioriza” prejudecățile tale. Ăsta e, într-adevăr, blestemul operatorului. Tu îi ceri sistemului AI trustworthiness, dar pe de altă parte, când i-ai dat feedback-ul pe baza căruia sistemul învață nu ai făcut-o trustworthy, ci ascultând de propriile tale prejudecăți.

Î: Deci până la urmă tot la eroare umană ne întoarcem, tot ființa umană este „not so trustworthy”. Pe de altă parte, așa cum am învățat de la Dvs., ființa umană e superioară AI, e mereu cu un pas înainte, dacă nu cu mai mulți. Nu vi se pare paradoxal?

HP: Ba da. Avem capacitatea și forța de a ne distruge și a distruge planeta asta, dar, în paralel, și forța de a o duce mai departe. Ați văzut filmul acela „On the beach/ Ultimul țărm (SUA, 1959, regia: Stanley Kramer, cu: Gregory Peck, Ava Gardner, Fred Astaire, Anthony Perkins, Donna Anderson ș.a.-n.n.)”? Cu submarinul acela, ultimul refugiu al rămășițelor umanității după ce toată omenirea e pustiită de norul radioactiv al unui război nuclear generalizat? Unul din personaje spune: „Sper, Doamne, că cel puțin tu ai înțeles ceva din povestea asta și existența oamenilor pe Pământul nu a fost în zadar!” Eu n-am dormit câteva nopți după ce am vizionat filmul, tot gândindu-mă la replica asta. Aici e mesajul. Sper că avem forța să învățăm din astfel de pericole. De aceea și petardele astea fanteziste care se mai lansează în spațiul public, cum e cel cu drona care vrea să-și ucidă operatorul, au farmecul lor și ne forțează să ne gândim la diverse posibilități. Ne fac să conștientizăm problemele.

Î: Se conturează o evoluție în care omenirea se împarte, se scindează între cei care dețin cunoștințele, informațiile, knowledge-ul, know-how-ul necesar, care e din ce în ce mai complex, din ce în ce mai greu de învățat la gura sobei; și o clasă a celor care nu mai pot face față, care pierd cursa? O situație ca aceea dintre patricienii și plebeii Romei antice, dintre nobilii și iobagii Evului Mediu?

HP: N-aș spune că pierd cursa, pentru că aici nu avem o cursă pentru supraviețuirea unei familii împotriva unei alte familii.

Î: Dar AI nu accentuează această tendință?

HP: Ba da, și n-ar trebui s-o facă. Ea se datorează fricii pe care AI o generează.

Î: Franklin Delano Roosevelt spunea că singurul lucru de care trebuie să ne fie frică e frica însăși…

HP: Avea dreptate. Așa e. Avem interferarea a două sau trei planuri. Conștiința omului că realizează instrumente tot mai complexe, care s-ar putea să-l facă redundant. Asta o simte oricine. Apoi mai sunt și oameni speriați de ideea telefonului mobil. Sunt oameni care nu pot să apese touchscreen-ul ca lumea, oameni care nu știu/ nu pot să manevreze un mouse cum se cade. Avem privilegiul să trăim în România. Când jumătate din țară locuiește la țară și are o structură mentală de genul „apăi mai stai o săptămână, ce bai are?”, îți dai seama că pentru oamenii ăștia timpul s-a oprit în loc. Ei nu au nici o treabă cu Inteligența Artificială, nici măcar nu știu ce este ea.

Î: Nu sunt ei perdanții? Nu se vor radicaliza? În ciclul SF “Dune” al lui Frank Herbert, se amintește de jihadul butlerian, acea revoltă pustiitoare a umanității, în genul mișcării ludiților din Anglia sec. XVIII, dar îndreptată împotriva calculatoarelor. Putem să ne gândim la ceva similar?

HP: În partea urbană pericolul există. În partea rurală a societății nu, pentru că oamenii aceia au o apropiere de natură pe care eu nu o mai am. Eu sunt om născut la oraș, între betoane. Dar și eu depind de natură. Nu pot să-mi explic de ce, dar depind de natură. Iar lor, celor de la țară, natura asta le dă forță, ei cumva se știu descurca acolo din strămoși. Pentru ei problema este automatul bancar. Dar dacă le dai un instrument simplu de tranzacționat cu bani virtuali- n-o să aibă probleme, câtă vreme nu-i obligi să meargă la automatul bancar și le spui foarte clar: „faceți schimburile voastre cum vreți voi, le plătiți așa și e în regulă“. Dacă procedezi în felul acesta, va fi OK. Să le rupi condiționarea de un element de interfață, care este rar la țară și care poate că îi și sperie cumva. Dincoace, la oraș, Inteligența Artificială ar putea să fie o problemă, pentru că reprezintă un termen pe care oamenii nu-l controlează, nu-l stăpânesc, nu știu la ce anume se referă și ar putea să deranjeze. De aici preocuparea mea pentru acest awareness raising, obsesia asta a mea cu ieșitul la berăria culturală, cu ieșitul în cetate, cu povestitul și explicarea către public. Mie mi se pare a fi o componentă obligatorie, necesară a profilului de universitar.

Î: Domnule profesor, îmi mai permiteți o întrebare? La final, impresia mea e următoarea: tot ce mi-ați spus, tot ce am absorbit, și am să reascult și banda- totul mi-a dat de înțeles că ne aflăm în pragul, dacă nu cumva chiar în mijlocul unor mutații fundamentale, fără precedent pentru ființa umană. Modul nostru de a exista ca ființe umane se va schimba dramatic, exponențial și în mai puțin de 50 de ani. Iar 50 de ani e puțin la scară istorică. Percepția mea e corectă? Și nu e doar a mea, cred că publicul simte asta- și de acolo nervozitatea generată de incertitudine, recursul la doctrine extremiste, totalitare…

HP: Sunt două elemente pe care le văd eu. Omului nu-i plac schimbările. Dacă-i vii în fiecare an cu câte o măsură și o inițiativă, cum vin companiile de comunicații cu câte o altă ofertă de telefon, el, omul, va începe să zbârnâie la tine, va deveni nervos. Pe de altă parte, s-ar putea ca avansul care urmează să se întâmple să survină extrem de repede și să fie pe model „totul dintr-o dată”. Și asta ajută. Dacă l-ai întinde pe o perioadă mai lungă, cu schimbări date cu țârâita, la a doua iterație, pragul de rezistență ar crește. Așa nu mai are timp s-o facă. De aceea sunt optimist: dacă i le dai pe toate la pachet, n-are probleme. Dar nu i le schimba domnule, în fiecare an, nu tărăgăna dându-i câte o felie, câte o picătură. Oamenii simpli- știți povestea aceea cu „fericiți cei săraci cu duhul”- nu sunt needucați, sunt apropiați de natură. Oamenii aceștia au forța lor, nu-i poți duce de nas. Dacă încerci să le servești o măsură trecându-i prin 10 iterații, cel mai târziu la a treia nu te mai iau în serios. Pe când dacă livrezi totul la pachet, omul simplu va găsi o logică în toate elementele respective în așa fel încât tot pachetul să aibă sens. Cu cât mai deodată, cu atât mai bine.

Foto: Horațiu Damian-UBB TechTransfer